ML aplicado al Riesgo de Crédito: construcción de modelos explicables

La Cátedra iDanae (inteligencia, datos, análisis y estrategia) en Big Data y Analytics, creada en el marco de colaboración de la Universidad Politécnica de Madrid (UPM) y Management Solutions, publica su newsletter trimestral correspondiente al 3T22 sobre Machine Learning (ML) aplicado al Riesgo de Crédito

ML aplicado al Riesgo de Crédito: construcción de modelos explicables

Introducción

En 2021 la EBA publicó un documento de debate sobre el uso de modelos de aprendizaje automático o machine learning (ML) para el cálculo de los requisitos de capital de las entidades bancarias [1]. En dicha publicación, la EBA realiza un análisis conciso de cómo el uso de nuevas técnicas y modelos sofisticados de ML podría coexistir con los requisitos prudenciales, identifica los principales retos y posibles beneficios del uso de los modelos de ML, y proporciona un conjunto de recomendaciones en el ámbito de los modelos IRB. El documento analiza cuatro aspectos principales:

- Los diferentes paradigmas de aprendizaje (supervisado, no supervisado y aprendizaje por refuerzo) que pueden utilizarse para entrenar modelos de ML. El uso de cada paradigma depende del objetivo del modelo y de los datos necesarios.

- Un conjunto de prácticas actuales en la modelización del riesgo de crédito. El uso de las técnicas de ML en los modelos IRB actualmente es limitado, y se utilizan generalmente sólo como complemento de un modelo tradicional cuando este se usa con fines regulatorios.

- Algunos desafíos y beneficios potenciales. Dependiendo del contexto en el que se utilicen, la complejidad y la interpretabilidad de algunos modelos de ML podrían plantear retos adicionales para que las instituciones desarrollen modelos IRB. De hecho, la explicabilidad es uno de los principales aspectos que impide a las instituciones aplicar plenamente las técnicas de ML en los modelos regulados. Esta cuestión se analizará más adelante en este documento.

- La identificación de cuatro pilares principales que deben estar presentes para apoyar el despliegue de técnicas de analítica avanzada, y que deben ser abordados de forma adecuada:

1. La gestión de datos

2. La infraestructura tecnológica

3. La organización y la gobernanza

4. La metodología

Además, la EBA incluye algunas recomendaciones específicas sobre los modelos, la interpretabilidad, la baja complejidad para su uso y las técnicas adecuadas para la validación de estos modelos.

También pueden surgir otros retos, por ejemplo: (1) la integración del juicio cualitativo con los modelos, lo que requerirá nuevas metodologías; (2) la disponibilidad de los datos1; (3) los requisitos de documentación de los modelos; (4) la formación de los analistas para entender y utilizar estos modelos; o (5) el evitar posibles sesgos o problemas de discriminación por motivos de raza, religión, sexo, etc.2, entre otros. El Banco de España también ha descrito detalladamente estos y otros retos en una publicación específica.

A pesar de todos estos retos, el interés en la implementación de técnicas modernas de ML para el capital regulatorio surge de la posibilidad de reducir los requerimientos de capital: según el Banco de España, la adopción de ML para tales fines podría reducir los requerimientos de capital entre un 12,4% y un 17%.

Además de la publicación de la EBA (que está dirigida a las entidades financieras), la Comisión Europea también ha publicado una propuesta de reglamento sobre la Inteligencia Artificial (IA), que también pretende potenciar el uso de la IA (véase el Cuadro 1).

Todo este contexto abre el interrogante para las instituciones financieras sobre la conveniencia y la forma de considerar los modelos de ML a efectos regulatorios, a pesar del reto que supone el cumplir con todos los requisitos ya establecidos para el proceso de modelización.

Entre todos los retos mencionados, la necesidad de explicabilidad en los modelos es uno de los que ha recibido especial atención por parte de los reguladores. Por ello, en este documento se analizan las implicaciones de este reto para las entidades financieras, así como diferentes enfoques sobre cómo abordarlo.

Cuadro 1. Propuesta de reglamento por el que se establecen normas armonizadas sobre la IAEn abril de 2021, la Comisión Europea publicó la "Propuesta de Reglamento por el que se establecen normas armonizadas sobre la IA" para establecer normas armonizadas para el desarrollo, la comercialización y el uso de los sistemas de IA.

Este documento prohíbe ciertas aplicaciones como el uso de IA que desplieguen técnicas subliminales más allá de la conciencia de una persona que puedan causar algún tipo de daño, o el uso de sistemas de identificación biométrica remota "en tiempo real" en espacios públicos con el propósito de hacer cumplir la ley |

El reto de la explicabilidad

Los modelos construidos mediante técnicas de ML deben ser comprendidos por los usuarios, lo que constituye uno de los principales retos a la hora de adoptar modelos de ML para el cálculo de los requisitos de capital. El Reglamento General de Protección de Datos (RGPD) establece que "El interesado tendrá derecho a no ser objeto de una decisión basada únicamente en el tratamiento automatizado, incluida la elaboración de perfiles, que produzca efectos jurídicos sobre él le afecte de forma similar". En otras palabras, los usuarios tienen derecho a una explicación de por qué el modelo ha tomado una determinada decisión.

No está claro hasta qué punto estas explicaciones deben ser precisas, fiables, completas o fieles al modelo original. El regulador no ha establecido qué metodologías son las apropiadas para este nuevo paradigma, mientras que el mundo académico ha estado aportando nuevas ideas en los últimos años bajo la etiqueta de explicabilidad, o xAI (inteligencia artificial explicable).

En cualquier caso, la explicabilidad tanto del modelo como de los resultados debe garantizarse de cara a la adopción de modelos de ML en el cálculo de los requerimientos de capital. Siguiendo el principio de explicabilidad del documento "Ethics guidelines for trustworthy AI" de la Comisión Europea, "los procesos deben ser transparentes, las capacidades y la finalidad de los sistemas de IA deben comunicarse abiertamente, y las decisiones -en la medida de lo posible- deben poder explicarse a los afectados directa e indirectamente" [6]. Además, según el CRR [7], la alta dirección debe comprender la estructura de los modelos dentro de su proceso de aprobación. Por lo tanto, las entidades deben ser capaces de explicar a sus clientes de forma fácil e intuitiva los elementos que determinan la decisión de un modelo de crédito.

Enfoques para la explicabilidad

Se pueden identificar dos enfoques principales para resolver el problema de la explicabilidad: (1) utilizar un modelo interpretable (por lo tanto, explicable) y mejorarlo utilizando técnicas de ML; (2) ajustar un modelo de ML y utilizar técnicas post-hoc para explicar sus predicciones.

Uso de modelos interpretables

Para abordar el primer enfoque, es importante responder la siguiente pregunta: ¿qué es un modelo interpretable? Aunque puede haber muchas respuestas diferentes, un modelo interpretable puede entenderse como un modelo que cualquiera puede memorizar y/o entender las relaciones entre las variables de entrada y la salida. En otras palabras, la relación entre las variables no tiene que ser necesariamente lineal, pero su relación debe ser sencilla.

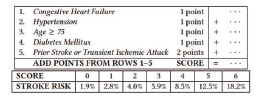

Esta definición depende de las limitaciones cognitivas humanas. Por ejemplo, un modelo lineal suele considerarse interpretable porque la relación entre la entrada y la salida es sencilla; sin embargo, un modelo lineal con 10.000 variables de entrada no debería considerarse interpretable sólo por ser lineal. Del mismo modo, un árbol de decisión es fácil de visualizar, pero un árbol de decisión con 10.000 divisiones no es directamente interpretable. A modo de ejemplo, la figura 1 es un ejemplo de modelo interpretable para la predicción de infartos.

Este es un caso particular de un modelo de puntuación ampliamente utilizado en el ámbito jurídico y médico en Estados Unidos [9]. Tiene pocas variables, todas las variables son relevantes según el juicio de los expertos (por ejemplo, el riesgo de infarto no debería depender de los ingresos o del color de los ojos), y las relaciones entre las diferentes entradas y salidas son sencillas de entender. El ejemplo anterior es un modelo interpretable, lo que implica explicabilidad (es decir, dada una predicción, es fácil entender por qué el modelo llegó a ese valor de riesgo concreto).

La lista de lo que podría considerarse modelos interpretables no es muy extensa: modelos lineales generalizados (GLM), modelos aditivos generalizados (GAM), árboles de decisión y modelos de puntuación o scoring. Sin embargo, incluso cuando se utilizan estos modelos, podrían incluirse técnicas de ML para mejorar los modelos interpretables mediante el uso de ML para la creación de nuevas variables para alimentar el modelo (feature engineering), la segmentación de los datos o la selección de variables (véase el Cuadro 2).

Los modelos interpretables tienen la ventaja de la explicabilidad, que puede complementarse fácilmente con el criterio de los expertos, pero el inconveniente de la propiedad intelectual: si un modelo es tan sencillo e interpretable como en el ejemplo del riesgo de infarto, puede ser memorizado e incluso objeto de ingeniería inversa. Esto puede provocar que el modelo acabe en manos de los competidores del sector, que podrían utilizarlo para mejorar el suyo.

La principal dificultad de este enfoque es la necesidad de un conocimiento experto, tanto en negocios como en disciplinas cuantitativas, que dé lugar a un preprocesamiento óptimo de los datos. Este preprocesamiento podría hacer que el rendimiento de un modelo tradicional fuera comparable al de los modelos de ML más modernos.

Utilización de técnicas de explicabilidad post-hoc

Muchos autores han demostrado las mejoras que puede suponer el uso de técnicas de ML en comparación con la regresión logística tradicional para el riesgo de crédito, llegando a aumentos del AUC del modelo hasta un 20% (respecto a la regresión logística). Sin embargo, hay autores que sostienen que esta diferencia se puede compensar con feature engineering y el conocimiento de los datos. Un caso especialmente interesante es el de Chen et al., 2018 [16] quienes ganaron un concurso de ML sobre riesgo de crédito con un modelo interpretable.

Este modelo podría resumirse como una red neuronal de dos capas con una función de activación sigmoide: en su primera capa agrupan las variables con un criterio experto para formar subpuntuaciones de riesgo (por ejemplo, las variables "número de operaciones totales" y "número de operaciones totales en el último año" se agrupan para formar la subpuntuación "frecuencia de operaciones"), y en la segunda capa combinan todas las diferentes subpuntuaciones en una predicción de puntuación final.

No obstante, las técnicas de ML parecen ser, en general, mejores que los humanos a la hora de extraer información o patrones de los datos. Dado que estos modelos no son interpretables, es necesario explicar cada predicción que el modelo realiza para que esta tecnología pueda ser utilizada.

Hay un ejemplo particular de un modelo ML que no es interpretable (según la definición de la sección anterior), pero que es fácilmente explicable: el algoritmo de K nearest neighbours (KNN). En este modelo, cada predicción se basa en el historial de los datos más cercanos al dato de entrada (con el tratamiento y la definición de distancia adecuados).

En otras palabras, para un modelo de scoring de crédito, se puede denegar el crédito a un cliente porque en los datos históricos hay clientes con características muy similares que entraron en default.

Para los modelos más complejos, como cualquier método ensenble basado en árboles, se ha desarrollado un conjunto de técnicas en el ámbito académico para explicar cada predicción. El ejemplo más popular de estas técnicas es LIME. Este método crea, para una predicción dada, un modelo interpretable. Se trata de un enfoque local, es decir, la explicación de una predicción no tiene por qué coincidir con otra. Los autores proponen otra técnica para elegir determinadas observaciones que proporcionan una visión global del modelo (SL-LIME). Este método también puede utilizarse para elegir el mejor de entre dos modelos, o para feature engineering. Se han desarrollado otras técnicas en este campo, como SHApley Additive exPlanation (SHAP) o permutation variance importance (VI).

Tanto LIME como SHAP fueron investigados en muchos trabajos4. Uno de ellos utiliza estos métodos para explicar los modelos basados en los clasificadores Random Forest, XGBoost, Logistic Regression, SVM y NN para la gestión del riesgo crediticio. La investigación consideró que estos métodos eran útiles debido a su capacidad para proporcionar explicaciones que se ajustan a la lógica financiera, como que los importes de los préstamos más bajos se asocian a una menor probabilidad de impago. Además, encontraron consistencia en las 20 características más importantes para los dos métodos diferentes estudiados, incluso cuando ampliaron su conjunto de datos de prueba. Otros autores destacan los inconvenientes que conducen a evaluaciones inestables y poco fiables. Estas desventajas hacen que los métodos sean fáciles de engañar, lo que se demostró utilizando datos de palabras reales de los ámbitos de la justicia penal y la puntuación de créditos. También se comprobó que LIME es más vulnerable al engaño que SHAP. Otro conjunto de trabajos de investigación probó estos algoritmos con datos simulados para comparar el resultado de los métodos con un proceso de generación de datos. Se descubrió que la explicación de LIME no puede considerarse estable en torno a cada punto de datos en un caso probado. Aunque la cantidad de artículos que enumeran las limitaciones de estos métodos es significativa, se está investigando para mejorarlos.

Una de las mejoras propuestas fue relajar uno de los supuestos de los Valores Shapley, la simetría, para crear Valores Shapley asimétricos que incorporan la causalidad en la explicabilidad del modelo. El método no sólo funciona mejor al tener en cuenta la correlación, sino que también podría funcionar para una selección de variables importantes sin necesidad de reentrenar el modelo. Otra mejora del método SHAP consiste en no analizar características distintas, sino agruparlas en función del conocimiento y la dependencia de las características. Este método se denomina groupShapley. Es importante saber que el usuario del método debe tener conocimientos sobre los datos, de lo contrario el método podría no presentar resultados significativo.

Banco de España propuso un método para evaluar dichas técnicas de interpretabilidad. Proponen la creación de conjuntos de datos sintéticos en los que se controla la importancia de las variables. Una vez que se ha ajustado un modelo a estos datos, se comprueba que los resultados de las técnicas de interpretabilidad se ajustan a los supuestos realizados al crear el conjunto de datos. El problema es que estos conjuntos de datos sintéticos no tienen por qué cubrir todo el espectro de posibles conjuntos de datos reales, que son generados por modelos estocásticos desconocidos. Del mismo modo, asegurar que un método de interpretabilidad funciona correctamente el 99% de las veces equivale a asumir que el 1% de los modelos implementados pueden ser defectuosos en el mejor de los casos o incluso injustos, con las consecuencias que estos tendrán para las personas y para la economía local.

El Banco de España también midió el impacto del uso de modelos avanzados de ML frente a una regresión logística en el cálculo del capital por riesgo de crédito. Concluyeron que las entidades podían ahorrar entre un 12,4% y un 17% aplicando un XGBoost en comparación con la regresión logística. El conjunto de datos utilizado fue proporcionado por una entidad financiera, anonimizando las variables para hacerlas irreconocibles, lo que impidió cualquier intento de preprocesamiento de datos por parte de los autores.

Por tanto, la eficacia de los métodos de ML más modernos en comparación con los modelos clásicos e interpretables está bastante aceptada, en ausencia de feature engineering. Sin embargo, en el caso de querer implementar estas técnicas, se han de desarrollar metodologías para poder confiar en el modelo y encontrar explicaciones para sus predicciones. Como inconveniente, hay que resolver la dificultad de incorporar el juicio de expertos con estos modelos, ya que es también uno de los requisitos normativos para el desarrollo de los modelos de crédito.

Cuadro 2. Diferentes alternativas para utilizar técnicas de ML con |

Conclusiones

La EBA ha abordado el debate sobre el uso de modelos de ML para el cálculo de los requisitos de capital o las puntuaciones de riesgo de crédito. Sin embargo, son muchos los retos que las entidades financieras deben abordar para integrar plenamente las técnicas de ML en los modelos regulatorios. Entre ellos, la explicabilidad es uno de los principales retos que hay que resolver.

Se recomienda la implementación de modelos tradicionales (como regresión logistica o lasso) para el cálculo del capital regulatorio, y evaluar asimismo el uso de modelos ML. Hay algunas reflexiones que hay que tener en cuenta, como el hecho de que las predicciones de los modelos ML pueden ser más precisas, pero no siempre pueden ser aplicables debido a la falta de explicabilidad en la predicción (entre otros posibles problemas). En tales casos, siempre debería ser posible volver al modelo tradicional.

El regulador no ha ofrecido aún directrices específicas sobre cómo afrontar este reto de explicabilidad, aunque ha destacado algunos posibles problemas que hay que tener en cuenta. En cualquier caso, las entidades deben dar una explicación a las predicciones de algunos modelos.

Tanto si se desea un modelo interpretable donde se han incorporado técnicas de feature engineering, como si se desea un modelo no interpretable junto con una herramienta de explicabilidad, el conseguir y formar personal para estas tareas seguirá siendo una necesidad en la industria.

La publicación ya está disponible para su descarga en la web de la Cátedra tanto en español como en inglés.